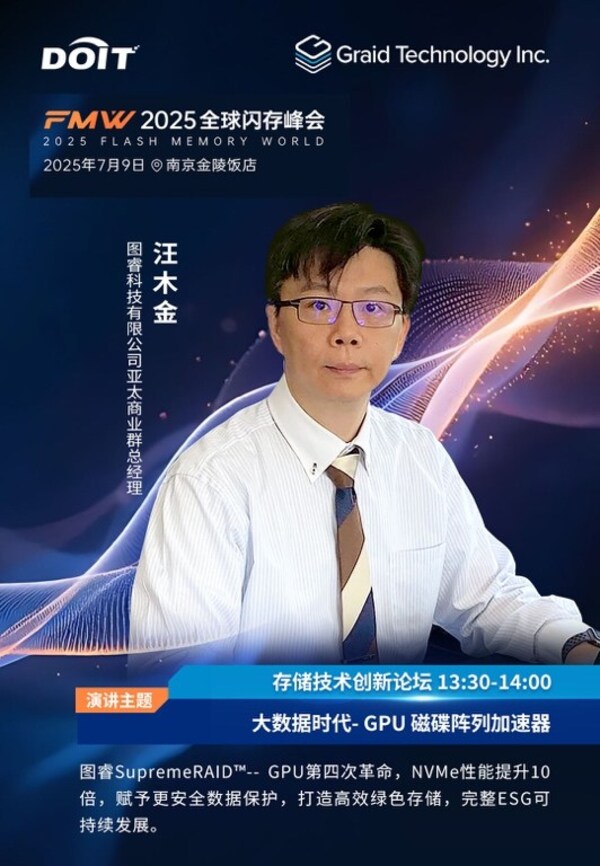

2025年7月9日,全球领先以GPU-based的磁盘陣列存储创新企业图睿科技(Graid Technology)将携旗艦產品SupremeRAID™及全方位一站式解决方案亮相南京举办的"全球闪存峰会(Flash Memory World 2025)"。届时,图睿科技亚太商业群总经理汪木金将发表主题演讲,AI、高性能计算(HPC)及大数据时代背景下,企业如何重塑数据基础设施,抢占智能化先机。

图睿科技亮相全球闪存峰会,GPU RAID引领端到端存储新格局

图睿科技亮相2025全球闪存峰会在南京 图睿科技成立于2020年,研发总部位于台北,专注于突破磁盘阵列在传统CPU架构上的性能瓶颈。其核心产品 SupremeRAID™ 是全球首款基于GPU架构的NVMe/NVMeoF RAID卡,凭借GPU强大的并行计算能力显著提升存储处理效率,单卡便可达到290GB/s读取与100GB/s写入速率,实现4至10倍以上的性能加速,大幅降低延迟,充分释放SSD潜能。同时,SupremeRAID™ 不仅全面支持RAID 0/1/5/6/10,还融合专利级数据保护技术-- 分布式日志机制实现RAID组态失效下的Write Hole数据找回及条带读失败重启动机制 ,显著延长SSD使用寿命,为数据密集型业务提供坚实保障。 面向日益增长的大数据及AI需求,图睿科技推出多元化高性能解决方案-- SupremeStore 高性能集群存储系统通过双主控服务器实现高可用架构(HA),结合SupremeRAID™ SR-1010与BeeGFS并采用InfiniBand互联,传输速率高达80GB/s,支持线性扩展及灵活横向扩充,完美适配AI、机器学习(ML)及HPC任务,满足模型训练及推理的多样化存储需求。同时,针对桌面端及边缘计算需求,图睿亦提供 Supreme100 等轻量化工作站,适合I/O密集型办公室及实验室场景。 在本届南京峰会上,图睿科技亚太商业群总经理汪木金将发表《大数据时代——GPU磁盘阵列加速器》主题演讲,深入剖析如何借助GPU RAID架构突破传统存储瓶颈,释放固态硬盘的极致性能,助力企业在AI浪潮中高效掌控数据,抢占市场先机,赢在未来。

图睿科技亮相全球闪存峰会,GPU RAID引领端到端存储新格局

存储创新技术论坛- 图睿GPU磁盘阵列加速器 同时,图睿科技积极践行ESG理念,将可持续发展融入产品设计。通过超高速传输性能,显著减少服务器部署及机架空间,降低数据中心能耗与碳排放,让企业资源更灵活地投入到算力建设之中,助力在实现业务增长的同时履行低碳运营与社会责任。 图睿科技诚邀各界合作伙伴、行业专家及媒体朋友于7月9日莅临全球闪存峰会图睿展台,近距离体验SupremeRAID™ 如何重构存储新格局,共同探索更快速、更安全、更绿色的数字未来。

|